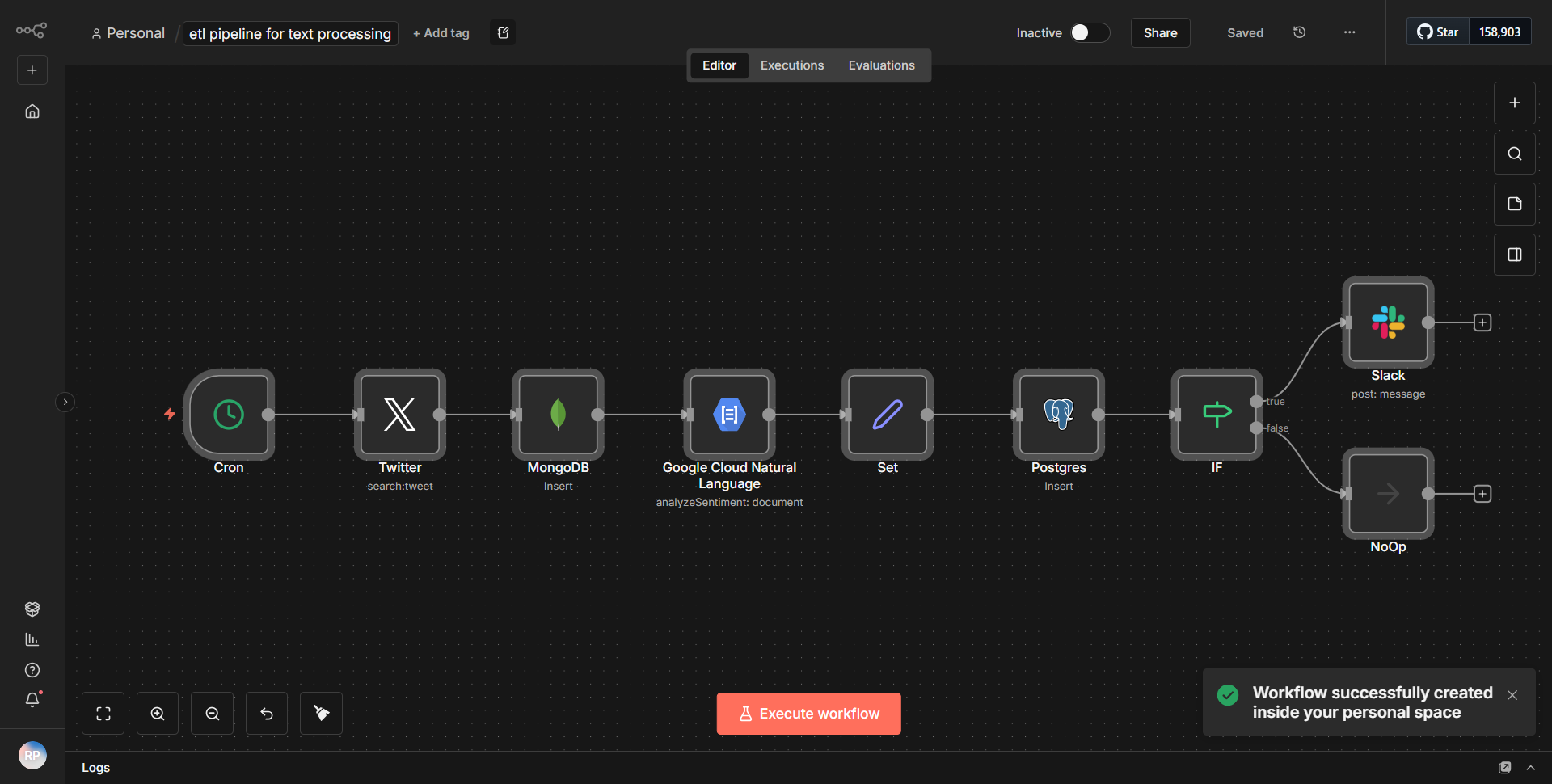

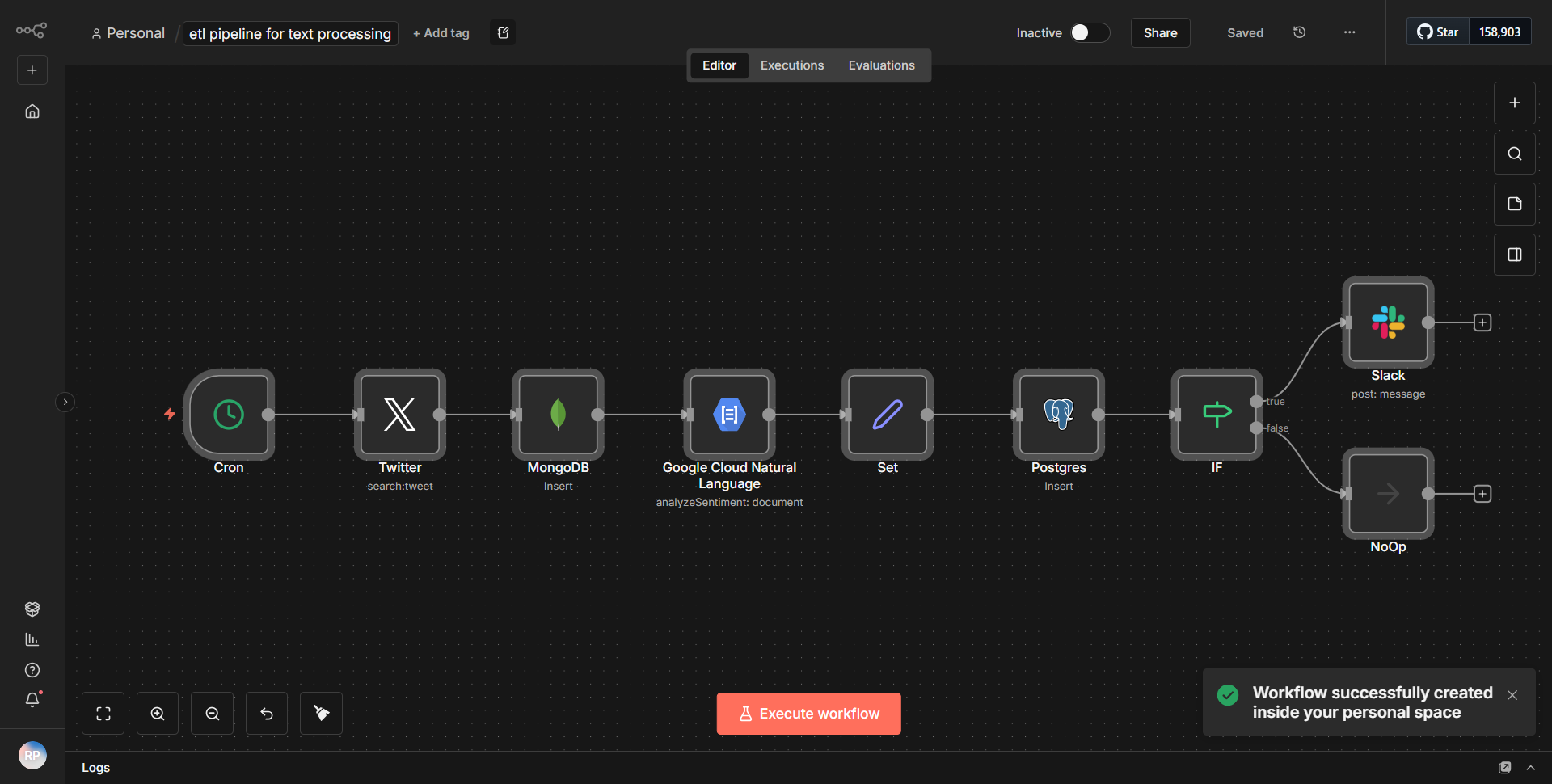

Fluxo de trabalho ETL de processamento de texto

Este fluxo de trabalho estabelece um pipeline ETL para análise de texto, recuperando informações do Twitter, salvando-as no MongoDB e PostgreSQL e enviando alertas para o Slack de acordo com a avaliação de sentimento.

Como funciona

O fluxo de trabalho ETL de processamento de texto foi projetado para facilitar um pipeline de ponta a ponta para análise de texto, com foco específico na recuperação de dados do Twitter, armazenamento no MongoDB e PostgreSQL e envio de alertas para o Slack com base na avaliação de sentimento. O fluxo de trabalho opera de maneira sequencial, utilizando vários nós para garantir fluxo e processamento de dados suaves.

1. Nó do Twitter:

o fluxo de trabalho começa com o nó do Twitter, que é configurado para recuperar tweets com base em critérios de pesquisa específicos. Este nó é responsável por buscar tweets em tempo real que correspondam aos parâmetros definidos, como palavras-chave ou hashtags.

2. Nó de análise de sentimento:

assim que os tweets são recuperados, eles são passados para um nó de análise de sentimento. Este nó processa o texto dos tweets para avaliar seu sentimento, categorizando-os como positivos, negativos ou neutros. Os resultados desta análise são cruciais para as etapas subsequentes do fluxo de trabalho.

3. Nó MongoDB:

após a avaliação de sentimento, o fluxo de trabalho direciona os dados de tweet processados, juntamente com sua pontuação de sentimento, para um nó MongoDB. Este nó é configurado para inserir as informações do tweet em uma coleção MongoDB, permitindo armazenamento e recuperação eficiente dos dados para análises futuras.

4. Nó PostgreSQL:

Simultaneamente, os mesmos dados processados são enviados para um nó PostgreSQL. Este nó é configurado para inserir as informações do tweet em um banco de dados PostgreSQL, garantindo que os dados sejam armazenados em formato relacional, o que pode ser útil para consultas estruturadas e relatórios.

5. Slack Node:

Finalmente, com base nos resultados da análise de sentimento, o fluxo de trabalho utiliza um nó Slack para enviar alertas. Se um tweet for classificado como tendo um sentimento negativo, um alerta será enviado para um canal designado do Slack, notificando os membros da equipe sobre conteúdo potencialmente preocupante.

Este fluxo estruturado garante que os dados não são apenas recolhidos e analisados, mas também armazenados em múltiplos formatos e comunicados de forma eficaz às partes interessadas relevantes.

Principais recursos

- Recuperação de dados em tempo real:

o fluxo de trabalho busca continuamente tweets do Twitter, permitindo uma análise oportuna do sentimento público sobre vários tópicos.

- Análise de sentimento:

a integração da análise de sentimento fornece informações valiosas sobre a opinião pública, permitindo respostas proativas a sentimentos negativos.

- Armazenamento de vários bancos de dados:

ao armazenar dados no MongoDB e no PostgreSQL, o fluxo de trabalho oferece flexibilidade no gerenciamento de dados, atendendo a diferentes casos de uso e requisitos de consulta.

- Alertas automatizados:

a integração do Slack garante que as partes interessadas sejam prontamente informadas sobre mudanças significativas de sentimento, facilitando a tomada de decisões e ações rápidas.

- Escalabilidade:

o fluxo de trabalho pode ser facilmente modificado para incluir fontes de dados ou etapas de processamento adicionais, tornando-o adaptável às necessidades analíticas em evolução.

Integração de ferramentas

- Twitter Node:

usado para buscar tweets com base em critérios de pesquisa especificados.

- Nó de análise de sentimento:

processa o texto dos tweets para determinar seu sentimento.

- Nó MongoDB:

armazena os dados do tweet em um banco de dados MongoDB para gerenciamento de dados não estruturados.

- Nó PostgreSQL:

insere dados de tweet em um banco de dados PostgreSQL para gerenciamento estruturado de dados.

- Slack Node:

Envia alertas para um canal do Slack com base na avaliação de sentimento dos tweets.

Chaves de API necessárias

- Chave de API do Twitter:

necessária para autenticar e acessar dados do Twitter.

- String de conexão MongoDB:

necessária para conectar-se ao banco de dados MongoDB.

- Cadeia de conexão PostgreSQL:

necessária para conexão com o banco de dados PostgreSQL.

- Slack Webhook URL:

Necessário para enviar mensagens para o canal Slack especificado.

Este fluxo de trabalho requer configuração adequada de chaves de API e cadeias de conexão para funcionar de forma eficaz, garantindo acesso seguro e autenticado aos respectivos serviços.