![Vector Database: AI エージェントのためのビッグ データ分析ソリューション [3/3 - 異常]](https://res.cloudinary.com/dwid2xvok/image/upload/v1764212703/n8n/screenshots/vector-database-as-a-big-data-analysis-tool-for-ai-agents-33-anomaly.png)

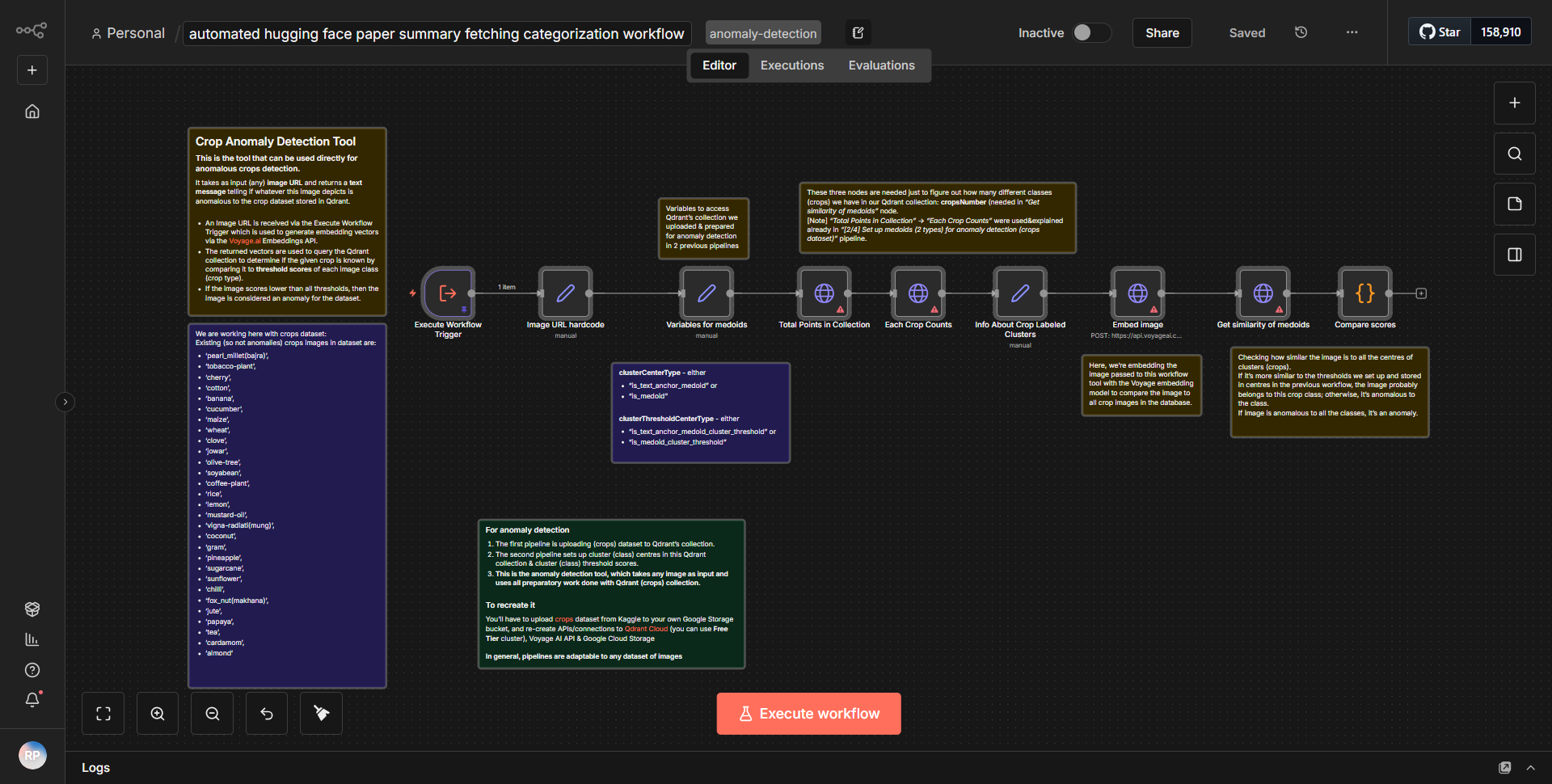

Vector Database: AI エージェントのためのビッグ データ分析ソリューション [3/3 - 異常]

AI エージェントの異常の特定に重点を置き、大規模なデータ分析のためのベクトル データベースの実装を完了します。

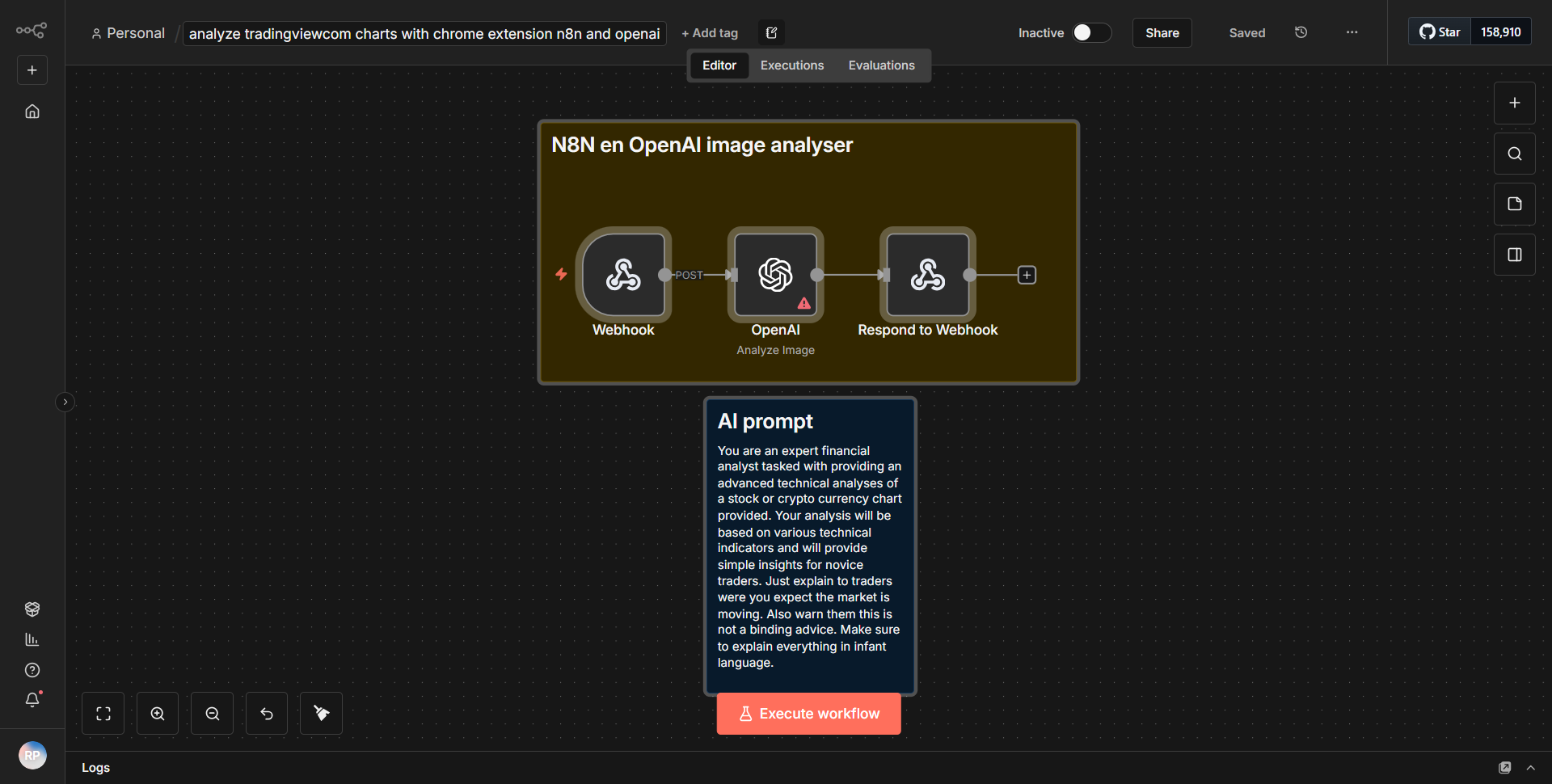

仕組み

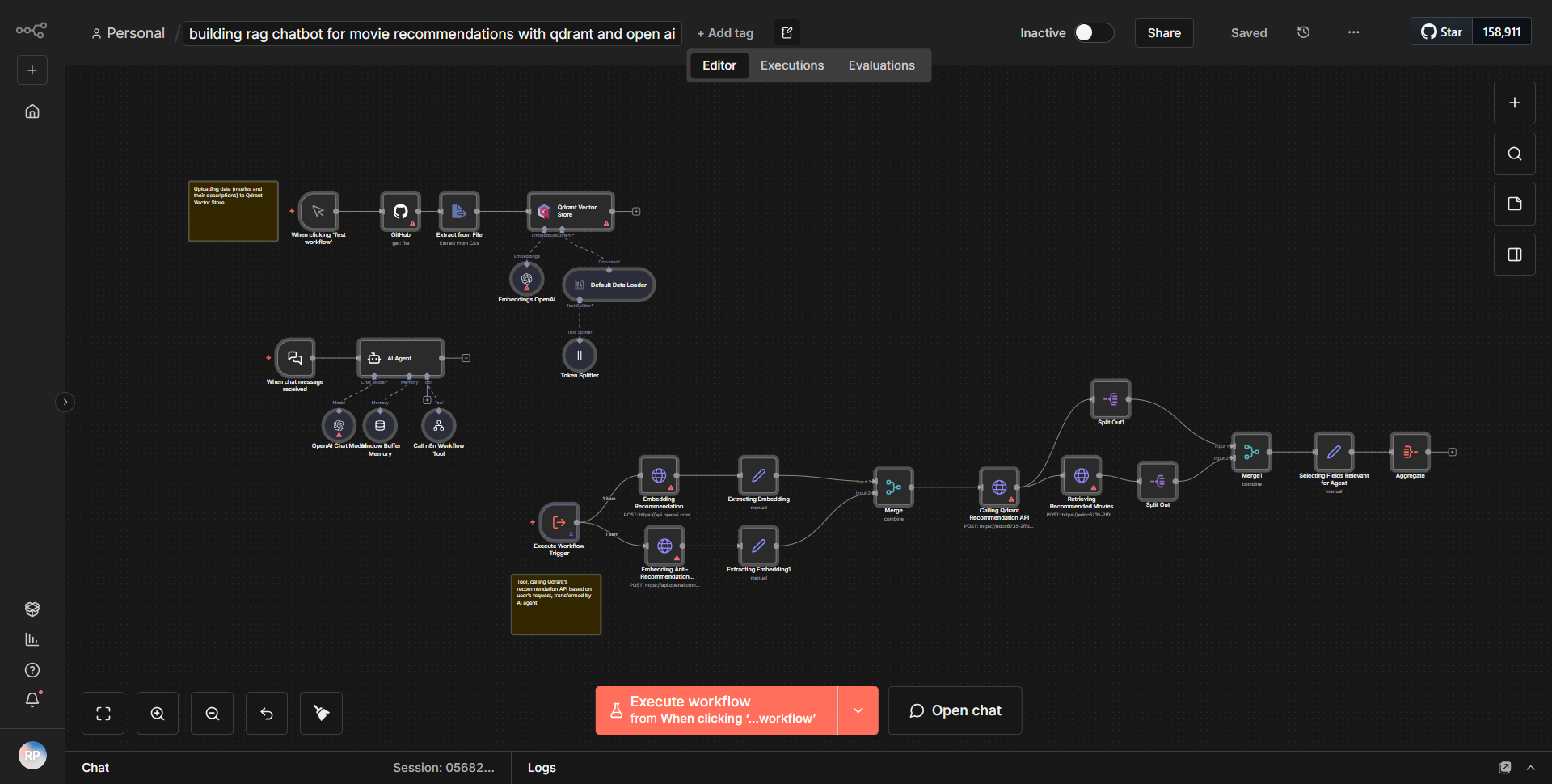

「ベクター データベース: AI エージェントのためのビッグ データ分析ソリューション [3/3 - 異常]」というタイトルのワークフローは、大規模なデータ分析、特に AI エージェントの異常検出に焦点を当てたベクター データベースの実装を最終的に完了するように設計されています。ワークフローは逐次的に動作し、さまざまなノードを利用してデータを効果的に処理します。

1. データ入力:

ワークフローは、指定されたソース (データベースまたは API) からデータを取得するノードから始まります。このノードは、異常を分析するために必要なデータセットを取得する役割を果たします。

2. データ処理:

データが取得されると、分析用のデータを準備する処理ノードに渡されます。これには、データのクリーニング、必要な形式への変換、場合によってはデータセット全体の一貫性を確保するための正規化が含まれる場合があります。

3. ベクトル化:

次のステップでは、処理されたデータをベクトル化します。これは、パターンや異常を分析できる形式にデータを変換するため、非常に重要です。ベクトル化ノードは、特定のアルゴリズムを利用して、データ ポイントを表すベクトルを作成します。

4. 異常検出:

ベクトル化後、ワークフローは異常検出アルゴリズムを使用します。このノードはベクトルを分析して、データセット内の外れ値や異常を特定します。この分析の結果は、問題や機会を示す可能性のある異常なパターンを理解するために重要です。

5. 出力生成:

最後に、ワークフローは、異常検出の結果に基づいて出力を生成するノードで終了します。この出力は、この情報を利用する AI エージェントの要件に応じて、レポート、アラート、データ視覚化などのさまざまな形式にすることができます。

このプロセス全体を通じて、データは 1 つのノードから次のノードにシームレスに流れ、各ステップが前のステップに基づいて構築され、最終的にデータセットの包括的な分析が行われます。

主な機能

- 異常検出:

このワークフローの主な機能は、大規模なデータセット内の異常を検出する機能であり、異常なパターンや動作を特定する必要がある AI エージェントにとって非常に貴重なものになります。

- ベクトル化:

ワークフローには高度なベクトル化技術が組み込まれており、より深い分析を容易にする効率的なデータ表現が可能になります。

- スケーラビリティ:

大規模なデータ分析用に設計されたワークフローは、広範なデータセットを処理できるため、ビッグ データ アプリケーションに適しています。

- 自動化:

ワークフローは、データの取得から異常検出までのプロセス全体を自動化し、手動介入を減らして効率を高めます。

- カスタマイズ可能な出力:

最終出力は、レポート、アラート、またはさらなるデータ処理など、特定のニーズに合わせて調整できます。

ツールの統合

ワークフローは、特定の n8n ノードを介していくつかのツールとサービスを統合します。

- HTTP リクエスト ノード:

外部 API またはデータベースからデータをフェッチするために使用されます。

- 関数ノード:

データ処理および変換タスクに使用されます。

- ベクトル化ノード:

データをベクトル形式に変換するためのアルゴリズムを実装します。

- 異常検出ノード:

ベクトルを分析して異常を特定します。

- 出力ノード:

希望の形式で最終結果を生成します。

API キーが必要です

ワークフローでは、その操作に必要な API キーや認証資格情報が指定されていません。データ ソースへの必要なアクセスが、ワークフローがデプロイされている環境内ですでに構成されていることを前提としています。

![Vector Database: AI エージェントのためのビッグ データ分析ソリューション [3/3 - 異常]](https://res.cloudinary.com/dwid2xvok/image/upload/v1764212703/n8n/screenshots/vector-database-as-a-big-data-analysis-tool-for-ai-agents-33-anomaly.png)