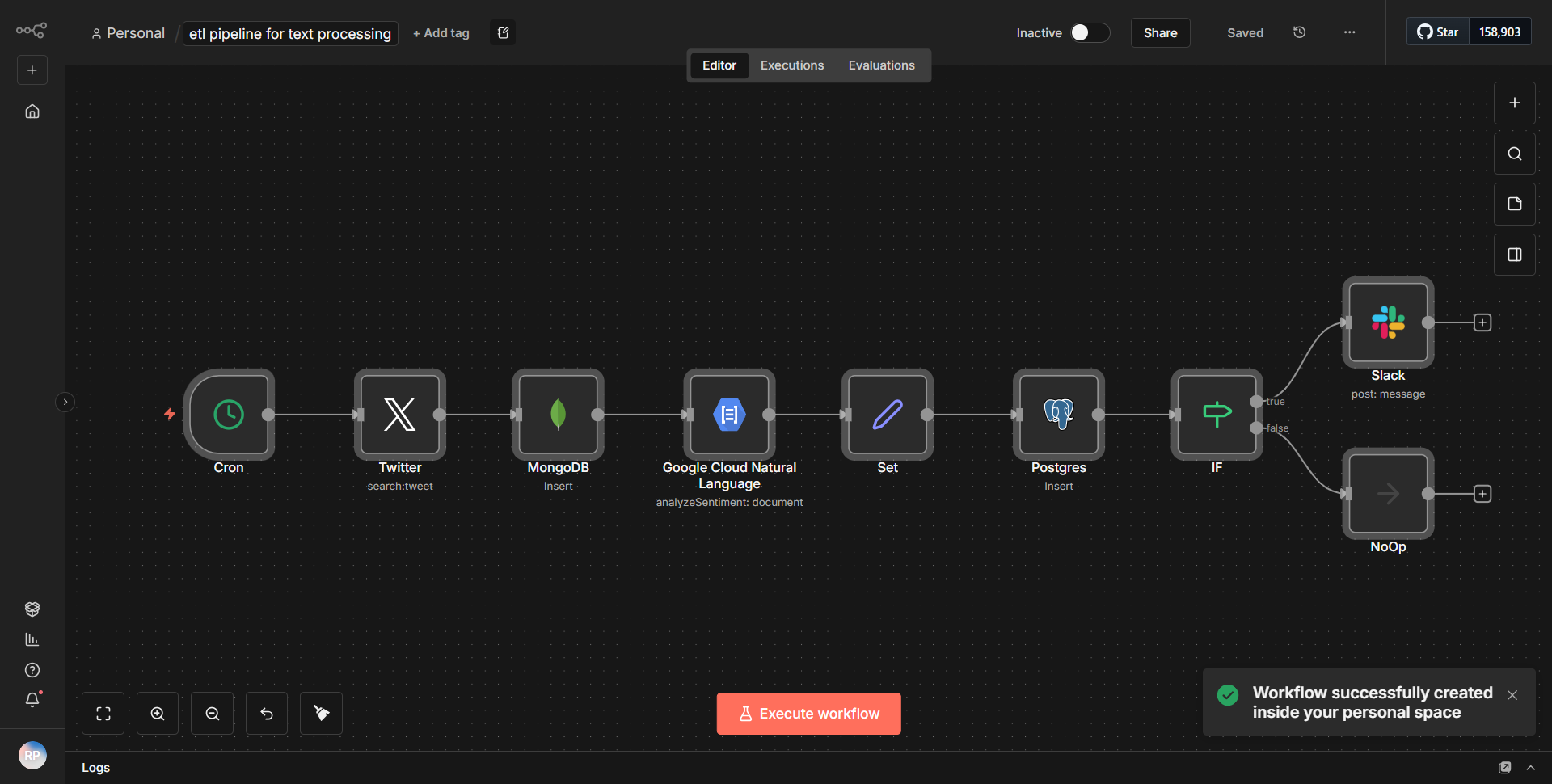

Textverarbeitungs-ETL-Workflow

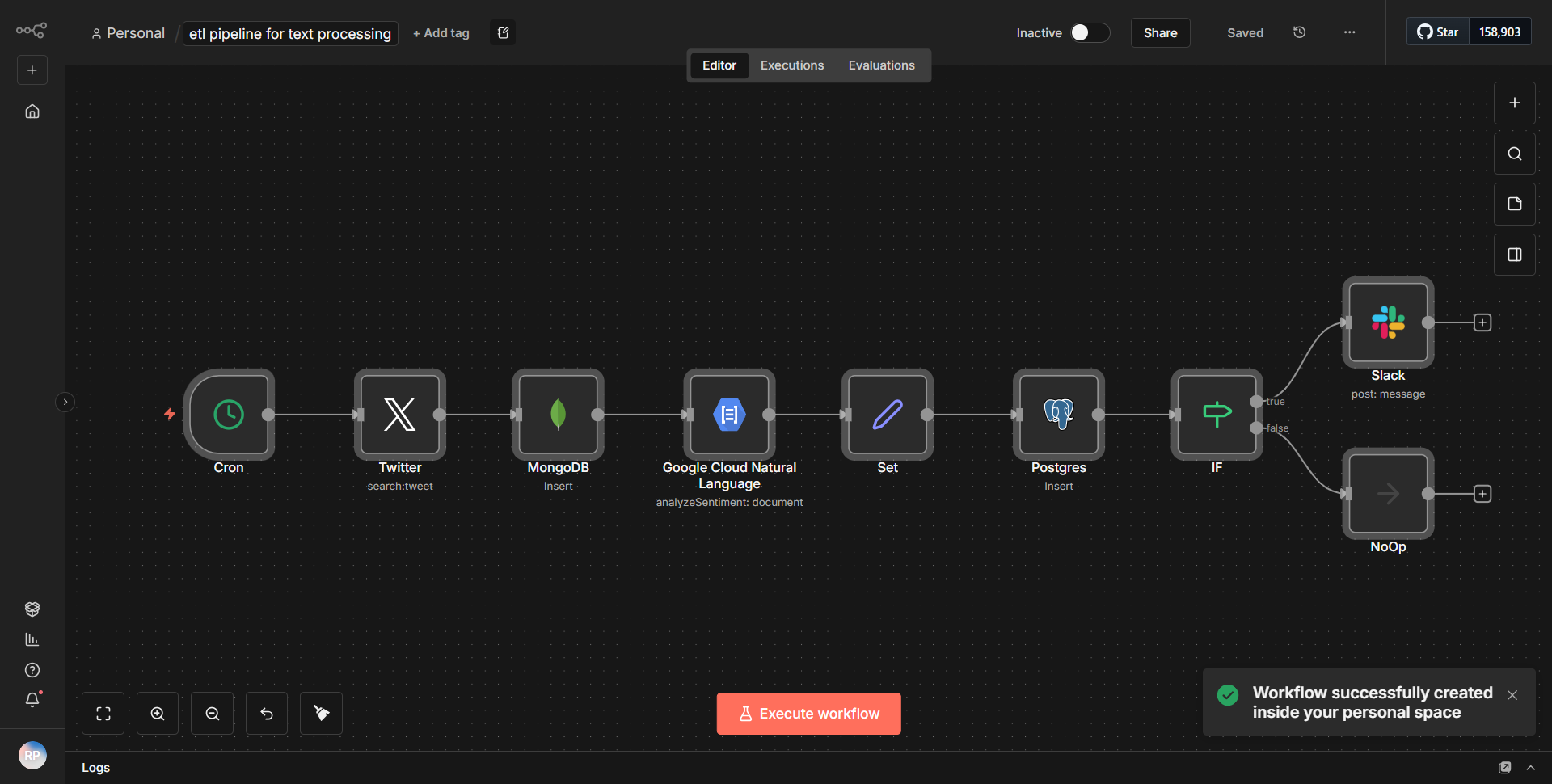

Dieser Workflow richtet eine ETL-Pipeline für die Textanalyse ein, ruft Informationen von Twitter ab, speichert sie sowohl in MongoDB als auch in PostgreSQL und sendet je nach Stimmungsauswertung Warnungen an Slack.

Wie es funktioniert

Der Textverarbeitungs-ETL-Workflow ist darauf ausgelegt, eine End-to-End-Pipeline für die Textanalyse zu ermöglichen, wobei der Schwerpunkt insbesondere auf dem Datenabruf von Twitter, der Speicherung in MongoDB und PostgreSQL sowie der Benachrichtigungsweiterleitung an Slack basierend auf der Stimmungsauswertung liegt. Der Workflow arbeitet sequentiell und nutzt verschiedene Knoten, um einen reibungslosen Datenfluss und eine reibungslose Verarbeitung zu gewährleisten.

1. Twitter-Knoten:

Der Workflow beginnt mit dem Twitter-Knoten, der so konfiguriert ist, dass er Tweets basierend auf bestimmten Suchkriterien abruft. Dieser Knoten ist dafür verantwortlich, Echtzeit-Tweets abzurufen, die den definierten Parametern wie Schlüsselwörtern oder Hashtags entsprechen.

2. Sentiment-Analyseknoten:

Sobald die Tweets abgerufen wurden, werden sie an einen Sentiment-Analyseknoten weitergeleitet. Dieser Knoten verarbeitet den Text der Tweets, um ihre Stimmung zu bewerten und sie als positiv, negativ oder neutral zu kategorisieren. Die Ergebnisse dieser Analyse sind entscheidend für die weiteren Schritte im Arbeitsablauf.

3. MongoDB-Knoten:

Nach der Sentiment-Auswertung leitet der Workflow die verarbeiteten Tweet-Daten zusammen mit ihrem Sentiment-Score an einen MongoDB-Knoten. Dieser Knoten ist so konfiguriert, dass er die Tweet-Informationen in eine MongoDB-Sammlung einfügt und so ein effizientes Speichern und Abrufen der Daten für zukünftige Analysen ermöglicht.

4. PostgreSQL-Knoten:

Gleichzeitig werden die gleichen verarbeiteten Daten an einen PostgreSQL-Knoten gesendet. Dieser Knoten ist so eingerichtet, dass er die Tweet-Informationen in eine PostgreSQL-Datenbank einfügt und so sicherstellt, dass die Daten in einem relationalen Format gespeichert werden, was für strukturierte Abfragen und Berichte nützlich sein kann.

5. Slack-Knoten:

Basierend auf den Ergebnissen der Stimmungsanalyse nutzt der Workflow schließlich einen Slack-Knoten, um Warnungen zu senden. Wenn ein Tweet als negativ eingestuft wird, wird eine Benachrichtigung an einen bestimmten Slack-Kanal gesendet, um die Teammitglieder über potenziell besorgniserregende Inhalte zu informieren.

Dieser strukturierte Ablauf stellt sicher, dass Daten nicht nur gesammelt und analysiert, sondern auch in mehreren Formaten gespeichert und effektiv an relevante Stakeholder kommuniziert werden.

Hauptmerkmale

- Datenabruf in Echtzeit:

Der Workflow ruft kontinuierlich Tweets von Twitter ab und ermöglicht so eine zeitnahe Analyse der öffentlichen Stimmung zu verschiedenen Themen.

- Stimmungsanalyse:

Die Integration der Stimmungsanalyse liefert wertvolle Einblicke in die öffentliche Meinung und ermöglicht proaktive Reaktionen auf negative Stimmungen.

- Multi-Datenbank-Speicher:

Durch die Speicherung von Daten sowohl in MongoDB als auch in PostgreSQL bietet der Workflow Flexibilität bei der Datenverwaltung und kann auf unterschiedliche Anwendungsfälle und Abfrageanforderungen eingehen.

- Automatisierte Benachrichtigungen:

Die Slack-Integration stellt sicher, dass Stakeholder umgehend über signifikante Stimmungsänderungen informiert werden, was eine schnelle Entscheidungsfindung und Maßnahmen erleichtert.

- Skalierbarkeit:

Der Workflow kann leicht geändert werden, um zusätzliche Datenquellen oder Verarbeitungsschritte einzubeziehen, wodurch er an sich ändernde Analyseanforderungen angepasst werden kann.

Tools-Integration

- Twitter-Knoten:

Wird zum Abrufen von Tweets basierend auf angegebenen Suchkriterien verwendet.

- Sentiment Analysis Node:

Verarbeitet den Text der Tweets, um deren Stimmung zu bestimmen.

- MongoDB-Knoten:

Speichert die Tweet-Daten in einer MongoDB-Datenbank für die unstrukturierte Datenverwaltung.

- PostgreSQL-Knoten:

Fügt Tweet-Daten zur strukturierten Datenverwaltung in eine PostgreSQL-Datenbank ein.

- Slack-Knoten:

Sendet Benachrichtigungen an einen Slack-Kanal basierend auf der Sentiment-Bewertung der Tweets.

API-Schlüssel erforderlich

- Twitter-API-Schlüssel:

Erforderlich für die Authentifizierung und den Zugriff auf Twitter-Daten.

- MongoDB-Verbindungszeichenfolge:

Wird für die Verbindung zur MongoDB-Datenbank benötigt.

- PostgreSQL-Verbindungszeichenfolge:

Erforderlich für die Verbindung zur PostgreSQL-Datenbank.

- Slack-Webhook-URL:

Erforderlich zum Senden von Nachrichten an den angegebenen Slack-Kanal.

Dieser Arbeitsablauf erfordert die ordnungsgemäße Konfiguration von API-Schlüsseln und Verbindungszeichenfolgen, um effektiv zu funktionieren und einen sicheren und authentifizierten Zugriff auf die jeweiligen Dienste zu gewährleisten.